Mit Storage Spaces Direct (S2D) bietet Microsoft im Windows Server 2016 Datacenter eine Technologie, welche es erlaubt mit mindestens zwei, maximal sechzehn physischen Servern und deren lokalen Festplatten und ohne komplexe SAN Infrastruktur eine hochverfügbare Software-defined Storage Lösung aufzubauen (Siehe dazu auch mein Artikel zu S2D: https://www.manfredhelber.de/windows-server-2016-storage-spaces-direct/). In Verbindung mit Hyper-V entsteht so eine Hyper-converged Lösung.

Ich werde allerdings immer wieder darauf angesprochen, dass die erforderliche Hardware vergleichsweise kostenintensiv wäre. Das ist natürlich eine Frage der Sichtweise. Für S2D wird keine iSCSI oder Fibre Channel Infrastruktur benötigt. S2D benötigt physische Server welche die Microsoft SDDC (Software Defined Datacenter) Zertifizierung für alle eingesetzten Komponenten besitzen. Netzwerkseitig werden je Server zwei NIC-Ports mit jeweils mindestens 10Gbit (RDMA ist empfohlen) benötigt und ab drei S2D Knoten zwei 10 Gbit Switches (zwei sollten es aus Gründen der Redundanz sein). Außerdem müssen die Serverknoten korrekt für Windows Server 2016 Datacenter lizenziert werden. Gegenüber traditioneller Cluster Lösungen wo wir zwei SAN-Boxen, iSCSI oder Fibre Channel Infrastruktur und mindestens zwei Server für den Windows Cluster benötigen ergibt sich bei Einsatz von S2D automatisch ein gewisses Einsparungspotential.

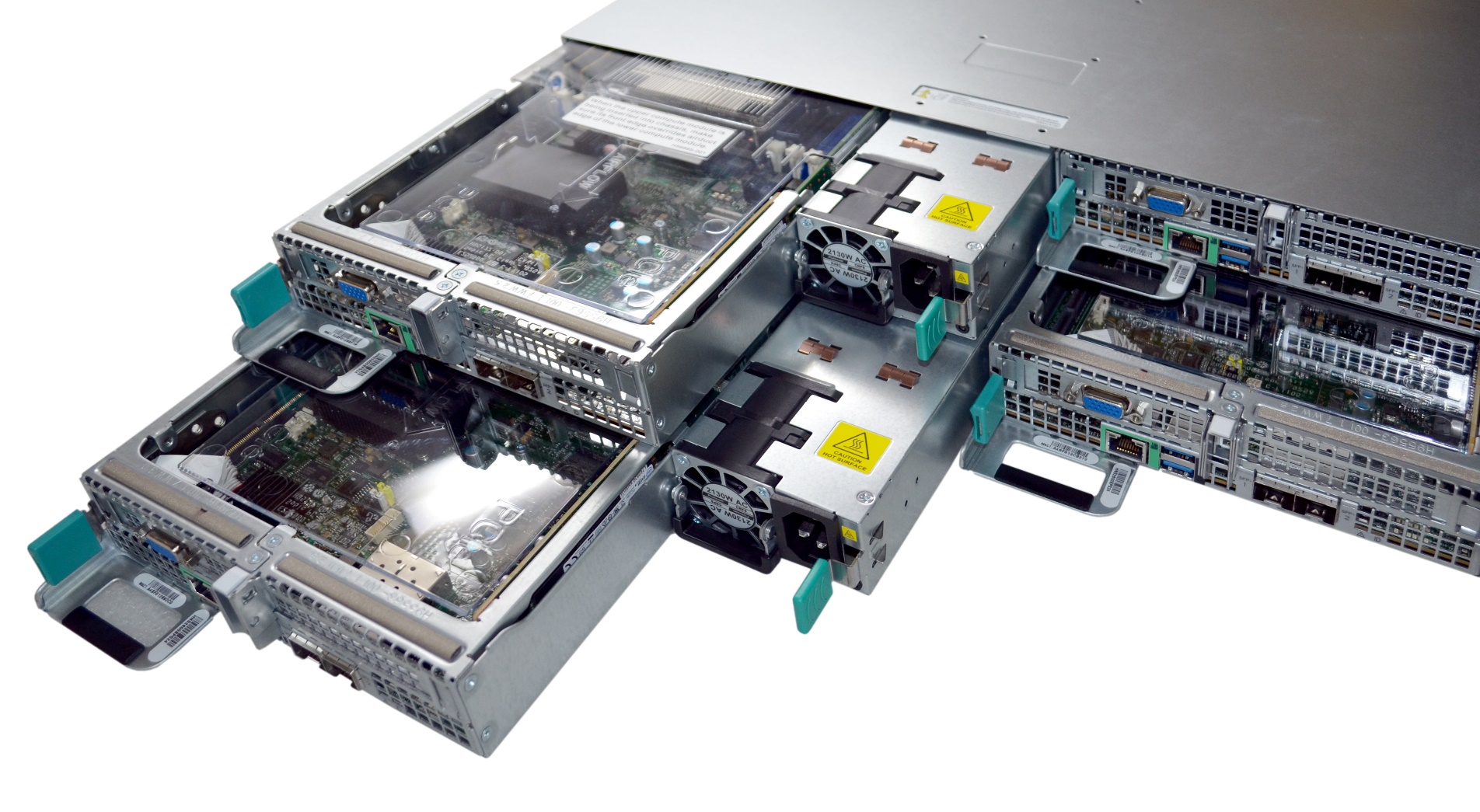

Aufgrund des Feedbacks habe ich mich am Markt umgesehen, ob es Systeme gibt welche eine noch weiter optimierte Implementierung von S2D ermöglich. Mit dem ICO Xanthos R26D bin ich bei einem ersten Hersteller fündig geworden:

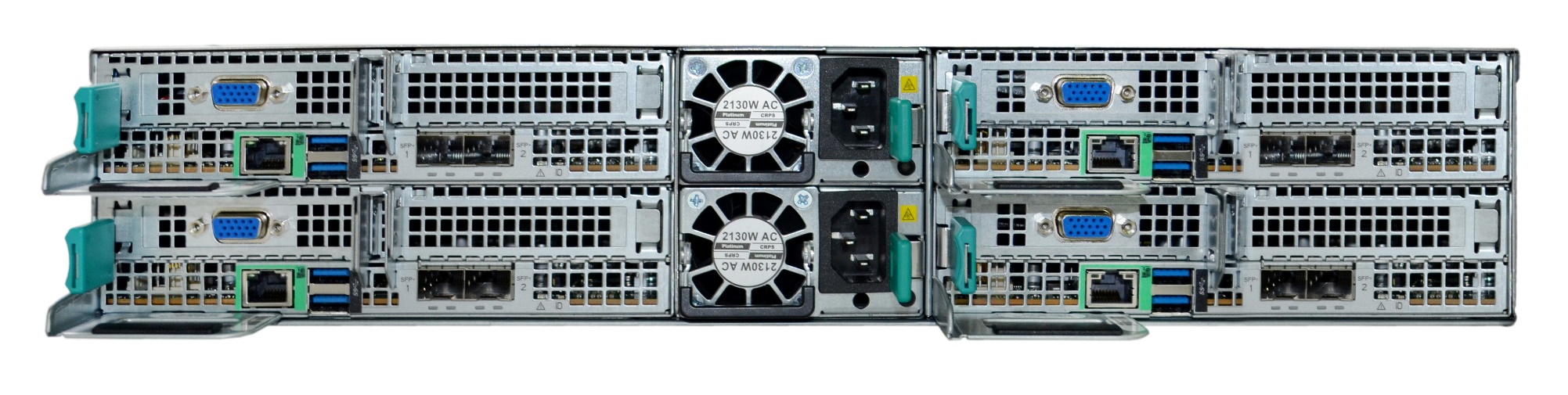

Auf den ersten Blick sieht das System wie ein klassischer Rack Server mit zwei Höheneinheiten aus. Bei genauerer Betrachtung des Systems, insbesondere von der Rückseite:

fällt auf, dass in dem zwei HE Rack Gehäuse insgesamt vier Server integriert sind. D.h. von der Rückseite aus sind die vier Server Module zugänglich welche jeweils wie folgt ausgestattet sind:

- 2x Intel® Xeon® Gold Prozessor 5115 (Skylake-SP) 10 Core / 2,4GHz

- 4x 32GB registered ECC FSB2666

- 1x 256GB Intel® NVMe SSD P3100 für Betriebssystem

- 2x Intel® 10GbE SFP+ mit RDMA Unterstützung

- 1x 1GbE dediziert für Intel® Remote Management

- 1x TPM2.0

Die 256GB Intel NVMe SSD P3100 wird für die Installation von Windows Server 2016 genutzt, damit alle Disk Slots für die S2D Konfiguration genutzt werden können.

Auf der Vorderseite finden sich die insgesamt 24x 2,5“ Disk Slots von welchen jeweils sechs den einzelnen Server-Knoten zugeordnet sind. In der Standard-Konfiguration stehen je Knoten folgende Disks zur Verfügung:

- 2x 960GB Intel® SATA SSD S4600 für Tiering

- 4x 2TB SAS Festplatte für Storage

Bei Konfiguration der 3-Wege Spiegelung (zwei Knoten dürfen gleichzeitig vollständig inkl. der zugeordneten Disks ausfallen ohne dass es zu einem Datenverlust kommt) stehen so 8 TB an netto-Kapazität zur Verfügung:

Durch die fast 2 TB Flash Speicher je Knoten ist eine sehr gute Performance zu erwarten.

Insgesamt stehen also in dem Gehäuse mit zwei Höheneinheiten 8x Intel® Xeon® Gold Prozessor 5115 (mit insgesamt 80 Kernen), 512 GB RAM und 8 TB Kapazität bei Konfiguration der 3-Wege-Spiegelung bei bester Redundanz und gleichzeitig minimaler Belastung der CPU zur Verfügung.

Für die erfolgreiche Konfiguration von S2D werden nur noch geeignete 10 Gbit Switches und 10 Gbit SFP+ Kabel benötigt. Außerdem müssen die Server-Knoten korrekt für Windows Server 2016 Datacenter lizenziert werden.

Ich werde das System in der genannten Konfiguration in den nächsten Wochen ausführlich testen. Dabei bin ich schon sehr auf die Leistungswerte gespannt! Insbesondere über die Unterschiede zwischen der Konfiguration mit 3-Wege Spiegelung mit 8 TB netto-Kapazität und die Konfiguration mit Dual Parity mit 12 TB netto-Kapazität werde ich berichten – das sind immerhin 4 TB zusätzliche netto-Kapazität durch eine reine Konfigurationsänderung – allerdings entsteht durch die Dual Parity ein etwas größerer Overhead auf den CPUs – mit insgesamt 80 Kernen dürften in dem ICO Xanthos R26D ausreichende Leistungsreserven vorhanden sein.

Alle Informationen zum ICO Xanthos R26D Finden Sie bei ICO unter: https://www.ico.de/ico-xanthos-r26d-4-node-server-fuer-2016-datacenter-storage-spaces-direct–y5410

Vergessen Sie bitte nicht das System korrekt für Windows Server 2016 Datacenter zu lizenzieren. Dadurch, dass alle Komponenten in einem Gehäuse mit 2 HE verbaut sind wird oft fälschlicherweise davon ausgegangen, dass dies Auswirkungen auf die Lizenzierung haben könnte. Dem ist nicht so! Betrachtet werden für die Lizenzierung die vier Servereinheiten welche Sie auf der Rückseite sehen – mit den jeweils 2x CPU mit jeweils 10 Kernen benötigen Sie also zur korrekten Lizenzierung insgesamt 4x die Windows Server 2016 Datacenter Basislizenz mit jeweils 16 Kernen und 4x die Windows Server 2016 Datacenter Erweiterungslizenz mit jeweils vier Kernen. Somit sind je Knoten 20 Kerne und in Summe 80 Kerne korrekt für Windows Server 2016 Datacenter lizenziert.

ICO bietet das System auch zusammen mit entsprechenden Windows Server 2016 Datacenter Lizenzen an: https://www.ico.de/ico-xanthos-r26d-4-node-server-inkl-2016-datacenter-storage-spaces-direct–y5411

Bei entsprechenden Fragen zum System können Sie sich an Sven Bauer bei ICO wenden:

Sven Bauer | Product Management

Tel: +49 6432/9139-401

S.Bauer@ico.de

Das beschriebene System wird mir für die Dauer der Tests von der Firma ICO zur Verfügung gestellt, damit ich der Community praxisbezogene Informationen bezüglich der Leistungsdaten und der Konfigurierbarkeit des Systems geben kann. Alle Informationen die ich zu dieser Lösung für S2D liefere sind also keine reinen Herstellerangaben, sondern wurden von mir selbst getestet. Nach Abschluss der Tests geht das System zurück an die Firma ICO.